6月13日,Meta(Facebook、Instagram等母公司)宣布开源了一款新的语言模型MusicGen,用户通过文本可直接生成音乐。

除了使用文本生成音乐之外,MusicGen还支持用户上传示例音乐,以增强音乐生成的准确性。例如,一首欢快的电子舞曲,带有切分音鼓、轻快的铺垫和强烈音乐波峰。然后再上传一首类似的歌曲《I Can't Stop》,点击生成即可。

「AIGC开放社区」体验了一下MusicGen,简单易用功能强大,资源消耗却很小。生成的音乐基本符合文本提示,音质通透、音频稳定、音峰抖动强烈等。总之,高音甜、中音准、低音稳,适合制作摇滚、舞曲、古典、流行、怀旧等背景音乐。

不得不感慨生成式AI的强大,普通人使用ChatGPT+MusicGen+Gen-2,仅用文字就能制作一部微型电影或音乐MV。可能目前效果还稍差一些,但5年、10年之后,到那时AI真的会颠覆文娱创作模式。

开源地址:https://github.com/facebookresearch/audiocraft

论文地址:https://arxiv.org/abs/2306.05284

免费在线测试地址:https://huggingface.co/spaces/facebook/MusicGen

MusicGen简单介绍

MusicGen是一种文本到音乐的语言模型。MusicGen采用的是单级自回归 Transformer(ChatGPT也借鉴了该模型)模型。该模型使用32kHz EnCodec 分词器,4个 50 Hz 采样的码本进行训练,并且一次可以生成4个样本。

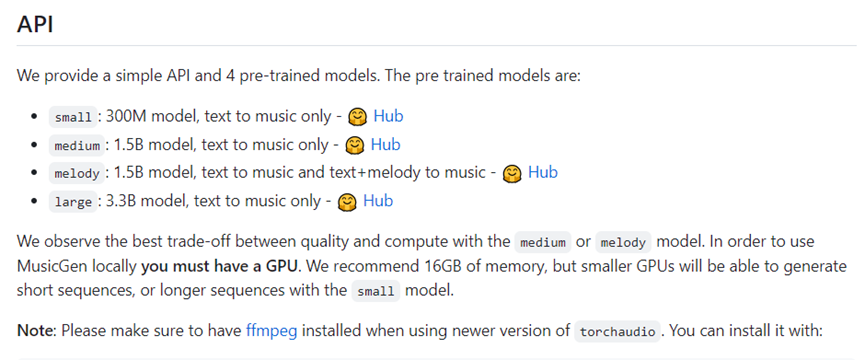

MusicGen拥有300M、1.5B和3.3B三种参数。如果在本地使用, 16G GPU内存就能运行。

MusicGen与 MusicLM、Riffusion、Musai等类似产品采用了不同的技术,不依赖自我监督的语义表示。而是以文本描述或旋律特征为条件,可以更好地控制音乐输出符合文本提示标准。

MusicGen模型使用了20,000小时的授权音乐数据进行训练,包括整个曲目和单个乐器样本。具体来说,MusicGen依赖于10000小时高质量音乐曲目的内部数据集,以及 ShutterStock和Pond5的音乐数据。

MusicGen使用方法

目前,Meta在https://huggingface.co/spaces/facebook/MusicGen提供了免费测试地址,使用方法非常,无需注册可直接使用。(目前测试人数较多,可能会出现连接错误提示,多刷新几次就行)

1)登录测试平台,在文本处输入一段描述,例如,带有旋律合成器、朗朗上口的节拍和动感强劲的低音,80年代电子摇滚风格。

2)如果想增强音乐输出的准确性,可以点击上传类似音乐。也可以不上传音乐直接点击【Generate】。

3)点击【Generate】,生产音乐即可。

MusicGen与同类产品对比

MusicGen与MusicLM、Riffusion等同类产品进行了比较,体现其功能的强大。例如,很强的旋律、热带打击乐和欢快节奏的流行舞曲,非常适合在海滩听,以下是三款同类产品生成的音乐。

从上面生成的音乐内容来看,MusicGen的音乐更通透、清晰、稳定,律动性也符合用户描述标准。更多音乐比较地址:https://ai.honu.io/papers/musicgen/

Meta表示,目前MusicGen还处于迭代、优化阶段,未来将开放模型训练代码以及更多的音乐功能,从而颠覆音乐行业的创作流程。

文章为用户上传,仅供非商业浏览。发布者:Lomu,转转请注明出处: https://www.daogebangong.com/articles/detail/Text%20directly%20generates%20music%20Metas%20new%20open%20source%20model%20MusicGen%20explodes.html

支付宝扫一扫

支付宝扫一扫

评论列表(196条)

测试