6月13日,Meta(Facebook、Instagram等母公司)宣布開源了一款新的語言模型MusicGen,用戶通過文本可直接生成音樂。

除了使用文本生成音樂之外,MusicGen還支持用戶上傳示例音樂,以增強音樂生成的準確性。例如,一首歡快的電子舞曲,帶有切分音鼓、輕快的鋪墊和強烈音樂波峰。然後再上傳一首類似的歌曲《I Can't Stop》,點擊生成即可。

「AIGC開放社區」體驗了一下MusicGen,簡單易用功能強大,資源消耗卻很小。 生成的音樂基本符合文本提示,音質通透、音頻穩定、音峰抖動強烈等。總之,高音甜、中音準、低音穩,適合製作搖滾、舞曲、古典、流行、懷舊等背景音樂。

不得不感慨生成式AI的強大,普通人使用ChatGPT+MusicGen+Gen-2,僅用文字就能製作一部微型電影或音樂MV。可能目前效果還稍差一些,但5年、10年之後,到那時AI真的會顛覆文娛創作模式。

開源地址:https://github.com/facebookresearch/audiocraft

論文地址:https://arxiv.org/abs/2306.05284

免費在線測試地址:https://huggingface.co/spaces/facebook/MusicGen

MusicGen簡單介紹

MusicGen是一種文本到音樂的語言模型。 MusicGen採用的是單級自回歸 Transformer(ChatGPT也藉鑑了該模型)模型。該模型使用32kHz EnCodec 分詞器,4個 50 Hz 採樣的碼本進行訓練,並且一次可以生成4個樣本。

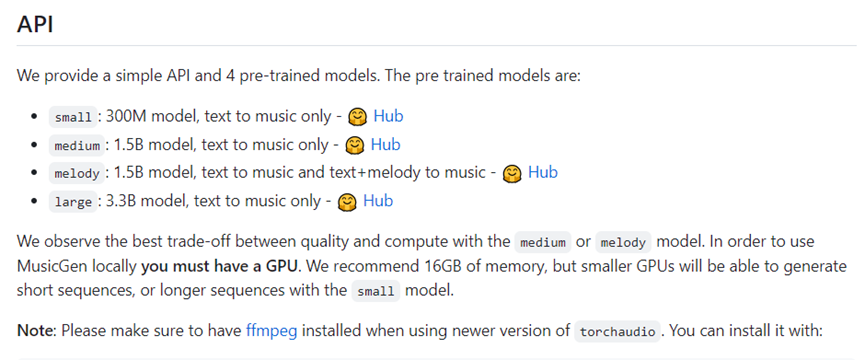

MusicGen擁有300M、1.5B和3.3B三種參數。如果在本地使用, 16G GPU內存就能運行。

MusicGen與MusicLM、 Riffusion、Musai等類似產品採用了不同的技術,不依賴自我監督的語義表示。而是以文本描述或旋律特徵為條件,可以更好地控制音樂輸出符合文本提示標準。

MusicGen模型使用了20,000小時的授權音樂數據進行訓練,包括整個曲目和單個樂器樣本。具體來說,MusicGen依賴於10000小時高質量音樂曲目的內部數據集,以及 ShutterStock和Pond5的音樂數據。

MusicGen使用方法

目前,Meta在https://huggingface.co/spaces/facebook/MusicGen提供了免費測試地址,使用方法非常,無需註冊可直接使用。 (目前測試人數較多,可能會出現連接錯誤提示,多刷新幾次就行)

1)登錄測試平台,在文本處輸入一段描述,例如,帶有旋律合成器、朗朗上口的節拍和動感強勁的低音,80年代電子搖滾風格。

2)如果想增強音樂輸出的準確性,可以點擊上傳類似音樂。也可以不上傳音樂直接點擊【Generate】。

3)點擊【 Generate】,生產音樂即可。

MusicGen與同類產品對比

MusicGen與MusicLM、 Riffusion等同類產品進行了比較,體現其功能的強大。例如,很強的旋律、熱帶打擊樂和歡快節奏的流行舞曲,非常適合在海灘聽,以下是三款同類產品生成的音樂。

從上面生成的音樂內容來看,MusicGen的音樂更通透、清晰、穩定,律動性也符合用戶描述標準。更多音樂比較地址:https://ai.honu.io/papers/musicgen/

Meta表示,目前MusicGen還處於迭代、優化階段,未來將開放模型訓練代碼以及更多的音樂功能,從而顛覆音樂行業的創作流程。

文章為用戶上傳,僅供非商業瀏覽。發布者:Lomu,轉轉請註明出處: https://www.daogebangong.com/zh-Hant/articles/detail/Text%20directly%20generates%20music%20Metas%20new%20open%20source%20model%20MusicGen%20explodes.html

支付宝扫一扫

支付宝扫一扫

评论列表(196条)

测试